2023.09.25

レポート

AIに関する国際的なルールメイキングと生成AIのインパクト

(1) 欧米における議論の動向

JIPDEC 電子情報利活用研究部 上河辺 康子

はじめに

2023年5月、日本が議長国を務めたG7広島サミットにおいて、G7首脳は、生成AIに関する議論のための広島AIプロセスを年内に創設1することとし、現在検討が進められつつある。本稿では、2回に分けて、生成AIを含むAIに関する規制の在り方に関する議論を紹介する。1回目である今回は、欧州連合、米国及び英国の取組みを取り上げる。

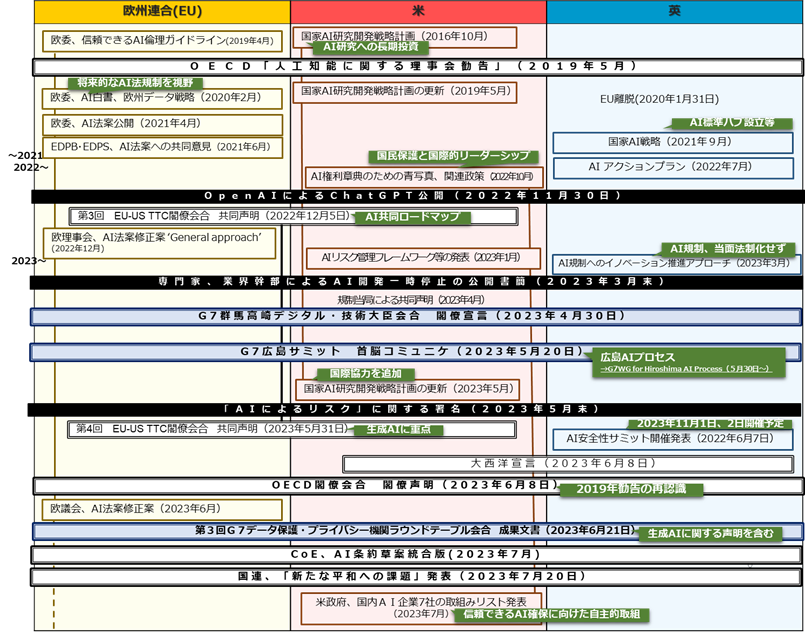

1.AI及び生成AIに関する議論の経緯

図1 AI及び生成AIに関する議論の経緯(※図1は、2023年7月までの状況をもとに作成)

AIに関する国際的なルールとしては、2019年5月にOECD閣僚会合で採択された人工知能に関する理事会勧告(OECD/LEGAL/0449)がある。OECDは、2016年よりAIに関する政策的議論の一助となる活動に取り組み、2019年の勧告では、信頼できるAIの責任あるスチュワードシップのための原則と、これらの原則と整合して国内政策及び国際協力の場で実行されるべき勧告が示された。このような国際的な議論の背景には、AI技術の進展と各国の対応があるが、2022年には生成AI利用が急激に拡大し、AIの専門家や経営者らによる署名活動が度々行われるなど、生成AIの開発や利用の在り方が国際的な課題となり、各国の政策や二国間、多国間の議論に影響を及ぼしつつある。

2.欧州連合

欧州連合(以下、EU)の執行機関である欧州委員会は、AI戦略に基づき、倫理的で安全な最先端のAI開発を支援するため、2018年6月にHigh-Level Expert Group on AI(AI HLEG)を設置、AI HLEGは信頼できるAIのための倫理ガイドラインを策定した。このガイドラインは、信頼できるAIは適法(lawful)、倫理的(ethical)かつ堅牢(robust)である必要があるとし、信頼できるAIのための倫理原則、倫理原則を満たすための要件及びAI評価リストを示した。欧州委員会は、AI HLEG の成果をふまえ、2020年2月に、将来的な法によるAI規制を視野に入れたAI白書を欧州データ戦略とともに公表、さらに、2021年4月にAI法案を提案した。AI法案では、リスクベースアプローチを採用し、許容できないリスクを持つAIシステムは原則禁止、ハイリスクなAIには要件が課せられる。禁止されるAIシステムとして、個人の意思決定を歪ませるAI(サブリミナル効果、年齢や障害など人々の脆弱性の利用)、公的機関によるソーシャルスコアリング、法執行を目的とした公にアクセスできる場所でリアルタイム遠隔生体識別システムの利用が挙げられた。このAI法案に対し、2021年6月に、欧州データ保護委員会(EDPB)および欧州データ保護監察機関(EDPS)が、ソーシャルスコアリングや公にアクセス可能な空間における個人の遠隔生体識別のためAI使用を全面的に禁止すべき等の意見を共同で提出した。また、欧州理事会は2022年12月2、欧州議会は2023年6月に、それぞれ異なる修正案を採択した。欧州議会の修正案は、欧州委員会提案から2年以上を経て提出され、その間の生成AIの急激な利用拡大を背景に、ChatGPTのような生成AIシステムはコンテンツがAIによって生成されたことを開示しなければならない等、生成AIに関する具体的な規制が含んでいる。今後は、早期の法の公布と施行を目指し、トリオローグを経てAI法の合意案の調整を行う方向とされている。

EUは、AIに関する研究開発において米国と協力関係にある。EU米間の新興技術や貿易の課題に取り組む枠組みであるEU-US Trade and Technology Council(TTC)の閣僚会合における議論を通じて、2022年12月に信頼できるAIの開発運用に向けた共同ロードマップを公開した。EU米の信頼できるAIのためのリスクベースアプローチの適用例として、EUのAI法、米国のAIリスク管理フレームワークやAI権利章典の青写真(後述)を挙げ、双方の規制アプローチの見解は異なるとしつつも、共通の価値観が新興技術を導くとしている。具体的な活動として、①用語と分類法の共有、②国際的な技術標準の開発活動と分析・ツール収集、③既存及び新たなAIリスクの監視と測定を進めることを挙げ、さらに、2023年5月、G7広島AIプロセスを補完する作業として、共同ロードマップ検討において生成AIを重視することが確認された。

- 2 欧州理事会は、2022年12月6日にAI法に関する共通の見解‘General approach’を採択した。

3.米国

米国は、2016年10月に策定した国家AI研究開発戦略計画を、2019年6月、2023年5月に更新した。同計画は、連邦政府の研究開発投資を調整し集中させるために、AIにおける主要な研究課題を定義するものであり、2016年の計画当初より、AI研究への長期投資を行うことを戦略の第一に掲げてきた。2023年5月の更新では、生成AIを含め、基礎的かつ責任あるAI研究に引き続き長期投資を行うとともに、新たに、AI研究における国際協力への原則的かつ協調的アプローチを確立することが追加された。

米国は、前述のEUと後述する英国との協力を含め、AI分野の国際協力を進めながら、国内の世界的AI企業との協力関係も構築し、自主的な規制への取組みを促そうとしている。

米国におけるAIに関するルールメイキングへの取組みとして、2022年10月に科学技術政策局(OSTP)が公開したAI権利章典のための青写真がある。AI等の自動化システムにより人々の監視やランク付けなどの問題が過去10年で劇的に拡大し人々の権利を脅かしているとして、安全で効果的なシステムやアルゴリズムによる差別からの保護など5つの保護策を示した。AI権利章典のための青写真公表と同日に、米政府は、技術分野の説明責任を進め国民の権利を守るための主要な行動を発表した3。この中には、労働者等の保護、教育者や医療提供者の支援に加えて、アメリカがAI分野のリーダーシップを維持することや、技術者の指導・支援も含まれた。技術者の指導・支援策の一つとして、2023年1月、国立標準技術研究所(NIST)がAIリスク管理フレームワーク(AI RMF 1.0)を公開した。フレームワークの目的は、信頼できる責任あるAIシステムの開発と使用の促進とされ、フレームワークは自主的なものとされている。

2023年7月21日4 、米政府は、安全、安心、信頼できるAIの確保に向けて、国内のAI企業7社による自主的な取組みについて8項目のリストを発表した。このリストには、AIで生成されたコンテンツであるかどうかをユーザーが理解できるようにするメカニズムの開発・展開、有害な偏見や差別の回避やプライバシーの保護などのAI システムによってもたらされる社会的リスクに関する研究の優先などが含まれている。同時に、米政府は、同盟国やパートナーとAIの開発と利用を管理する国際的枠組みを確立すると発表した。発表によれば、米国は既に、日本、英国、仏独伊等のヨーロッパ諸国、アジア太平洋諸国など20か国と協議し、国連やその加盟国ともAIについて議論している。

また、米政府は、米国内のAI企業の自主的な取組みの確保について、7月の7社に続き、2023年9月12日に、新たに8社と、製品の安全性の確保等に取り組むことを確認5した。

米国では、民間の活動も活発に行われている。AI利用に関して、脚本家や俳優がストライキを実施し、新聞大手がAI学習のための記事利用禁止を利用規約に含めた6。一方、米民間AI企業4社は、2023年7月26日、AI利用の安全性のための業界団体Frontier Model Forumの設立を発表した7。フォーラムは、今後1年間、ベストプラクティスの特定、AIの安全性の研究促進、企業と政府間の情報共有促進の3点に焦点をあてて活動するとしている。

- 3 FACT SHEET: Biden-Harris Administration Announces Key Actions to Advance Tech Accountability and Protect the Rights of the American Public、米ホワイトハウス発表、2022年10月4日

- 4 FACT SHEET: Biden-Harris Administration Secures Voluntary Commitments from Leading Artificial Intelligence Companies to Manage the Risks Posed by AI、米ホワイトハウス発表、2023年7月21日

- 5 FACT SHEET: Biden-Harris Administration Secures Voluntary Commitments from Eight Additional Artificial Intelligence Companies to Manage the Risks Posed by AI、米ホワイトハウス発表、2023年9月12日

- 6 利用規約4(3)(The New York Times Company)

- 7 Frontier Model Forum

4.英国

英国は、2020年にEUを離脱した。英国の国家AI戦略(2021年9月策定、2022年12月更新)は、「英国はAIにおける世界的な大国」であり「今後10年間で世界をリードする立場にある」として、政策上の3つの柱と、柱毎の短期(今後3か月)、中期(今後6か月)、長期(今後12か月以上)の計画を示し、その進捗状況を監視・評価するためのメカニズムを導入するとした。2022年7月に公開されたAIアクションプランは、国家AI戦略の進捗状況を概観し、毎年更新するとされており、戦略の進捗状況を監視・評価するためのメカニズムの一環と考えられる。国家AI戦略は、中期計画のひとつにAI標準ハブの設立を挙げ、世界的なAIの技術標準策定に貢献するとしている。AIアクションプランによれば、AI標準ハブについては、英アラン・チューリング研究所が、英国規格協会(BSI)と国立物理学研究所(NPL)が支援を得て、試験運用を主導することとなり、その後、2022年10月より運用が開始された8。

2023年3月、英国科学技術省は、AI規制へのイノベーション推進アプローチを示し、この中でAI標準ハブは、信頼できるAIのためのツールと位置付けられている。また、AI規制について、指針となる安全性・セキュリティ・堅牢性、適切な透明性と説明可能性等の原則を挙げつつも、企業に対する厳しい法的抑制はイノベーションを抑制するとして、AI規制の原則を、当面は法制化しないとしている。

英政府は、2023年6月7日、今秋英国においてAIの安全性に関する初のグローバルサミット(以下、AIセーフティサミット)を開催予定であると発表した。サミットにおける検討は、G7、OECD、AIに関するグローバル・パートナーシップでの最近の議論に基づくものであると説明している。翌6月8日の米英首脳会談では、英国によるAIセーフティサミット開催に米国が歓迎の意を示すとともに、両国がOECD、国連、AIグローバル・パートナーシップ、欧州評議会、国際標準化機構、G7広島AIプロセスを含む国際的な活動を歓迎しAIもたらすリスクと機会に関してさらに前進すること、CBPRフォーラムやOECDへの支援を含めたデータセキュリティリスクに関する共通の理解を構築することなどが確認され、成果文書である大西洋宣言に盛り込まれた。

2023年8月24日、英国政府は、AIセーフティサミットの開催日程を2023年11月1日、2日と発表9、さらに、2023年9月4日、AIセーフティサミットでは、AIシステムにより生み出されるリスクや安全なAIによる公共の利益に焦点をあてる方針を示した10。

おわりに

欧州連合、米国、英国は、「信頼できるAI」のための政策を打ち出しているが、欧州連合は法制度、米国は民間による自主規制、英国は標準化に重点を置き、信頼できるAI実現に向けた規制アプローチはそれぞれ異なる。次回は、G7等の国際的な枠組みにおける議論を紹介したい。

参考文献

- OECD、人工知能に関する理事会勧告、OECD/LEGAL/0449、2019年5月22日

- 欧州委員会、Artificial Intelligence for Europe、2018年4月25日

- 欧州委員会AI HLEG、Ethics Guidelines for Trustworthy AI、2021年4月8日

- 欧州委員会、WHITE PAPER On Artificial Intelligence -A European approach to excellence and trust、2021年2月19日

- 欧州委員会、Proposal for a Regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence (Artificial Intelligence Act) and amending certain Union legislative acts、2021年4月21日

- 欧州データ保護委員会及び欧州データ保護監察機関、EDPB-EDPS Joint Opinion 5/2021 on the proposal for a Regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence(Artificial Intelligence Act) 、2021年6月18日

- 欧州理事会、Proposal for a Regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence (Artificial Intelligence Act) and amending certain Union legislative acts- General approach、2022年11月25日

- 欧州議会、Amendments adopted by the European Parliament on 14 June 2023 on the proposal for a regulation of the European Parliament and of the Council on laying down Artificial Intelligence Act and amending certain Union legislative acts、2023年6月14日

- TTC Joint Roadmap on Evaluation and Measurement Tools for Trustworthy AI and Risk Management、2022年12月1日

- OSTP、National Artificial Intelligence Research and Development Strategic Plan、2016年10月

- OSTP、National Artificial Intelligence Research and Development Strategic Plan: 2019 Update、2019年6月

- OSTP、National Artificial Intelligence Research and Development Strategic Plan: 2023 Update、2023年5月

- OSTP、Blueprint for an AI Bill of Rights、2022年10月4日

- NIST、Artificial Intelligence Risk Management Framework (AI RMF 1.0)、2023年1月26日

- Department for Science, Innovation and Technology他、National AI Strategy、2021年9月21日(2022年12月18日更新)

- Department for Science, Innovation and Technology他、National AI Strategy⁻AI Action Plan、2022年12月18日

- Department for Science, Innovation and Technology他、A pro-innovation approach to AI regulation、2023年3月29日

- The Atlantic Declaration、2023年6月8日

JIPDEC電子情報利活用研究部 上河辺 康子

- ヘルスケアサービスにおけるデータ利活用に関する調査

- 企業情報化動向調査

- JIS Q 15001原案作成団体事務局 など

■協会外の主な活動

‐プライバシーマーク主任審査員

‐プライバシーマーク審査基準委員(保健医療福祉分野)

‐ヘルスケア・PHR関連団体参加